Spark 使用说明¶

在星光平台上的 Spark 应用配置信息如下:

name |

Spark |

Python |

Java |

OS |

|---|---|---|---|---|

MMLSpark |

2.4.3 |

3.7 |

1.8.0 |

Ubuntu 16.04 |

Apache-Spark |

2.4.3 |

3.7 |

1.8.0 |

Alphine-Linux |

MMLSpark 使用说明¶

首先先提交作业:

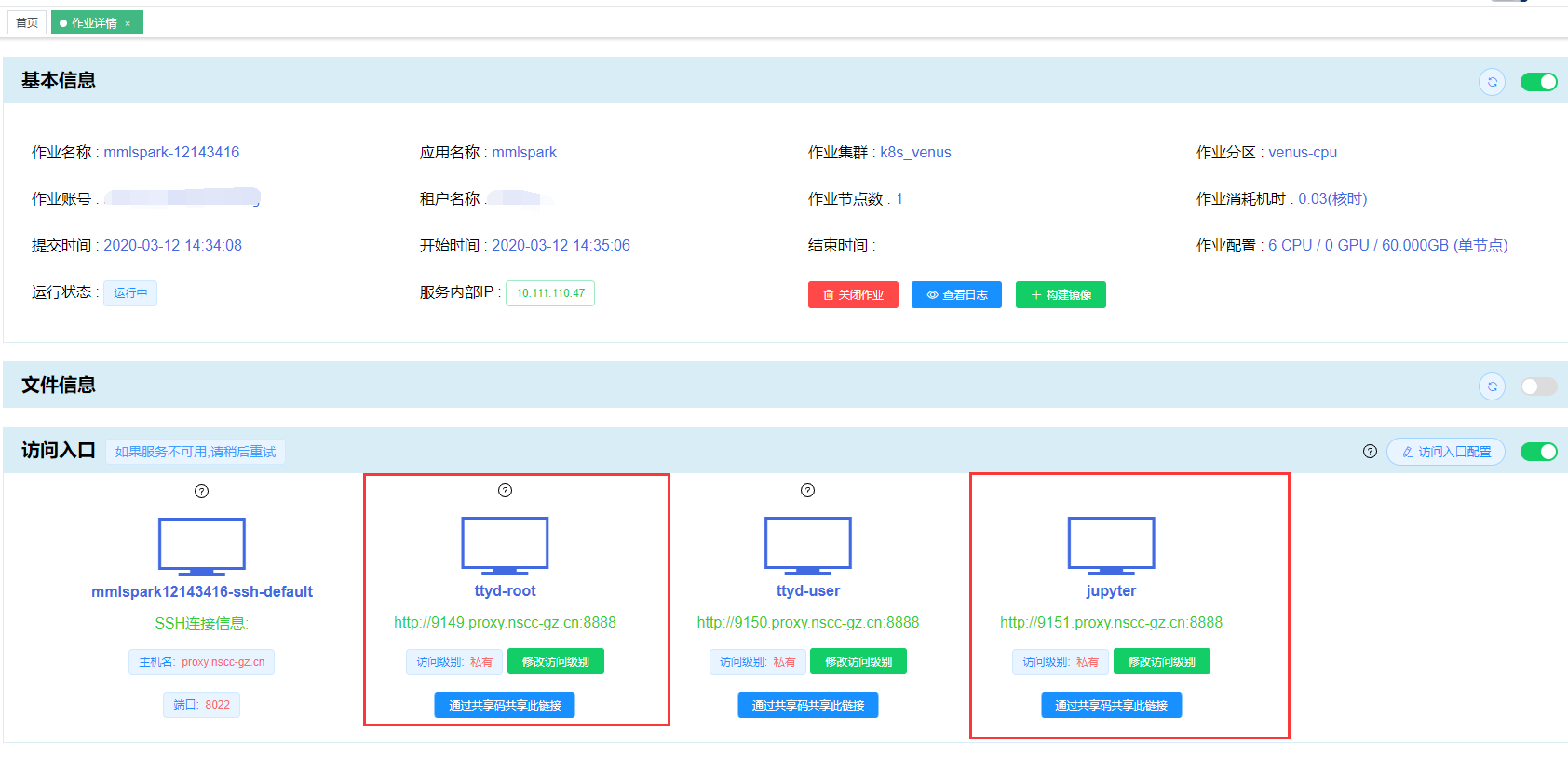

提交成功后自动进入作业详情界面:

通过访问入口访问应用,以 jupyter 和 ttyd-root 访问入口为例:

通过 Jupyter 访问 MMLSpark¶

点击 “jupyter” 访问入口:

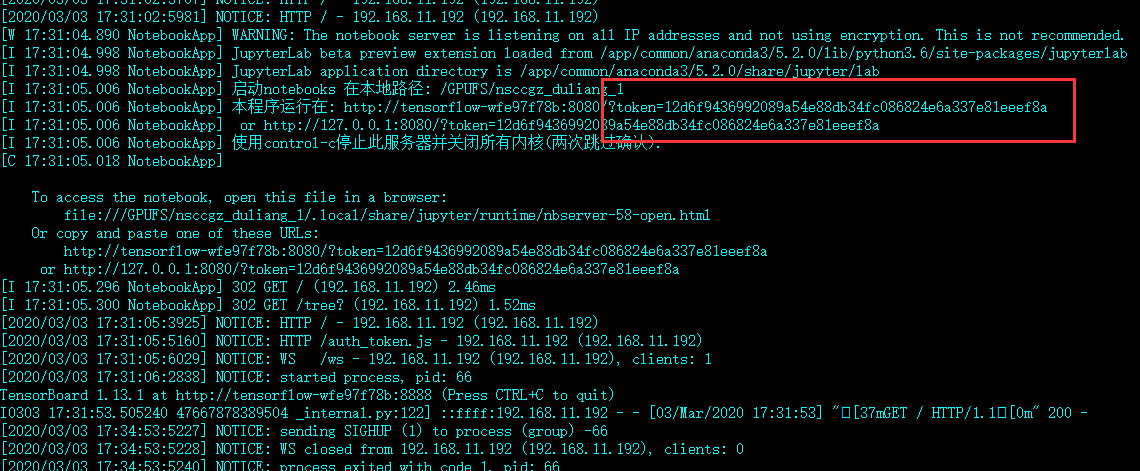

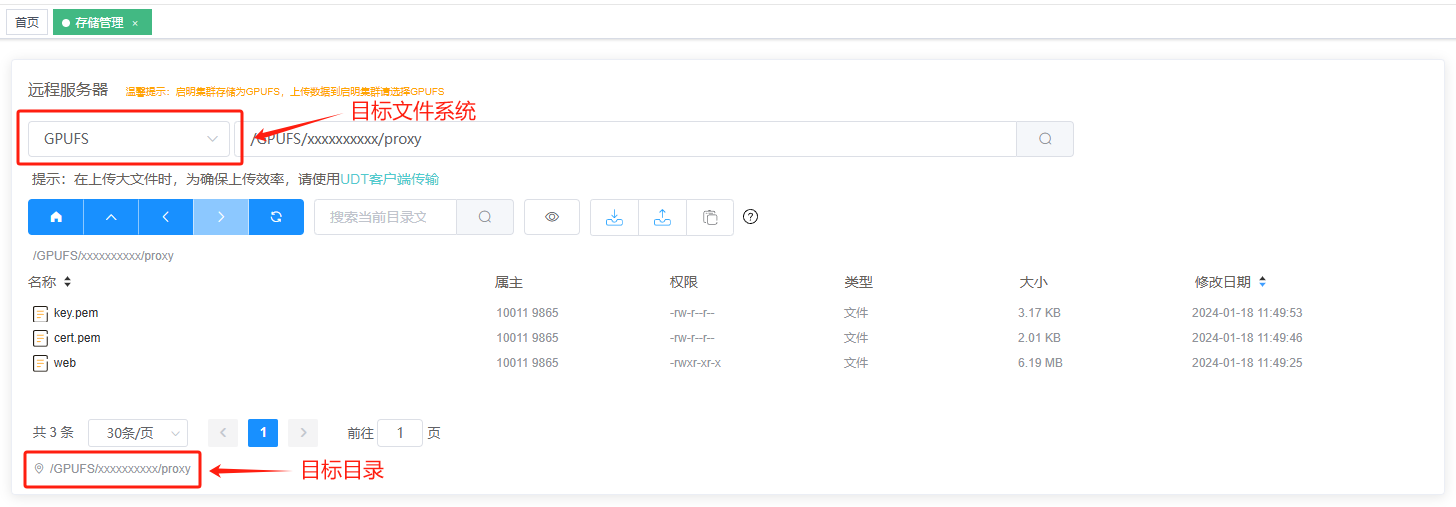

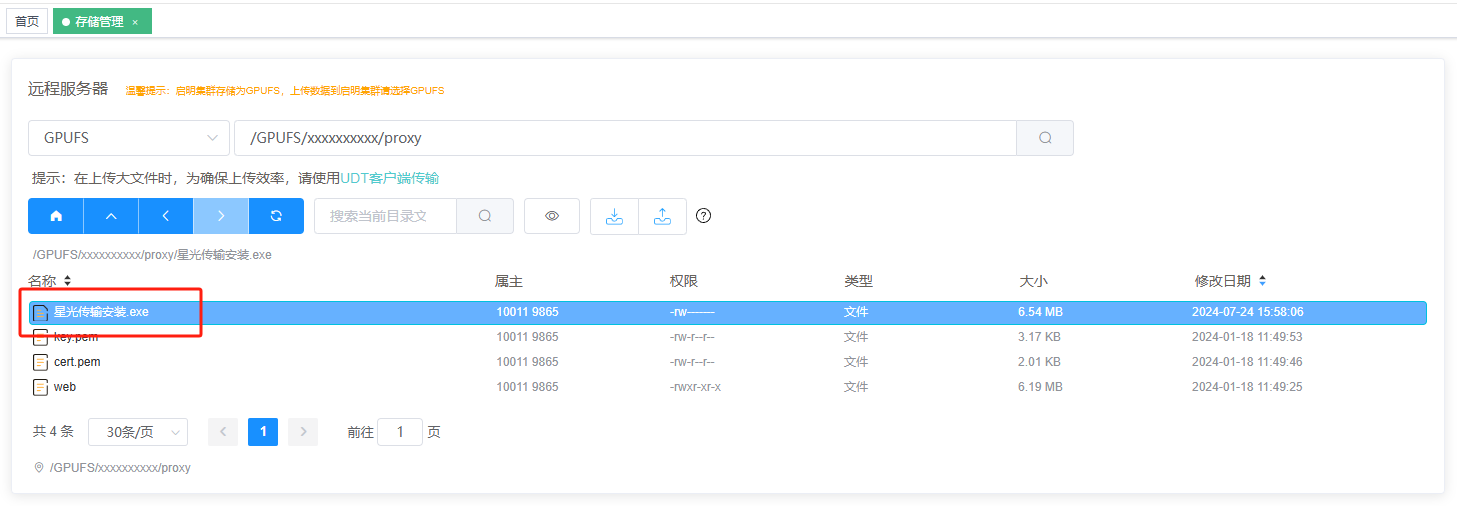

使用 jupyter 登录需要 token 信息,token 信息需要到 “基本信息” 的 “查看日志” 中查看:

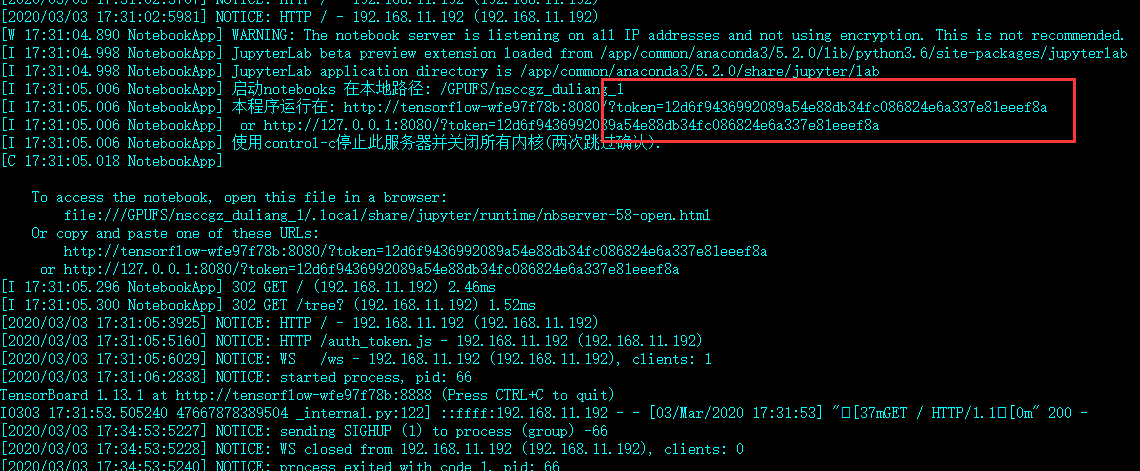

点击 “查看日志” 按钮,把日志拉到最后,可看见类似下面的 token 信息:

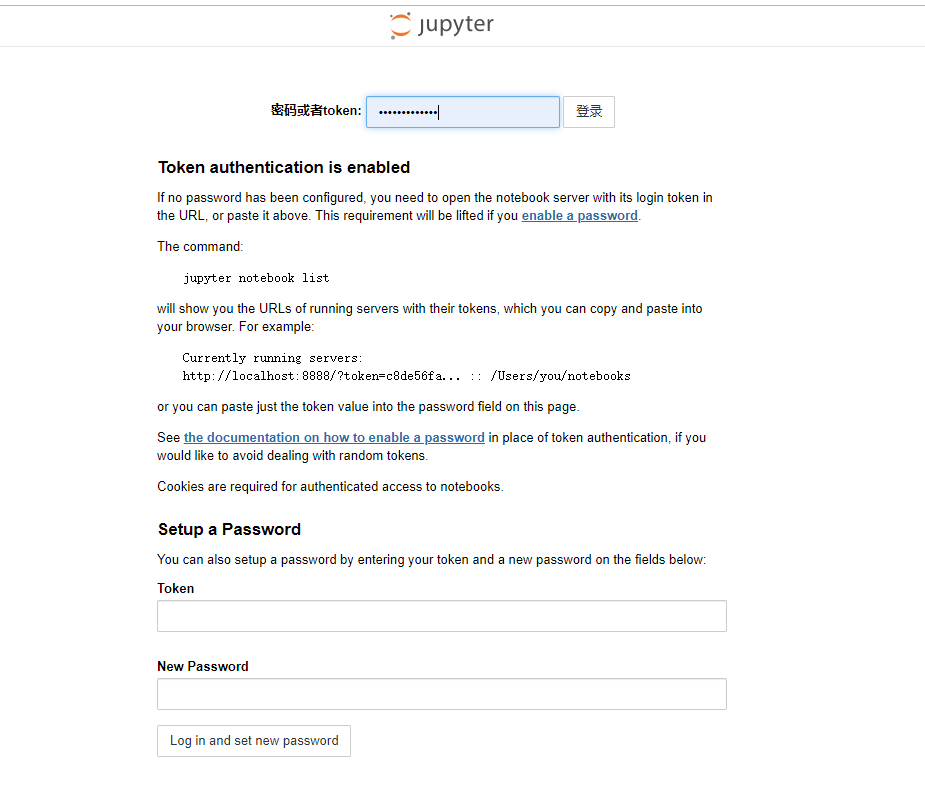

将 token 输入后点击 “登录” 按钮:

出现类似以下界面则表明登录成功:

通过 ttyd-root 访问 MMLSpark¶

点击 “ttyd-root” 访问入口,使用 ttyd-root 访问入口访问应用:

Apache-Spark 使用说明¶

Apache-Spark 支持集群模式,以下演示一个 Spark 集群的创建步骤:

启动 Spark-Master¶

提交 Spark-Master 应用作业:

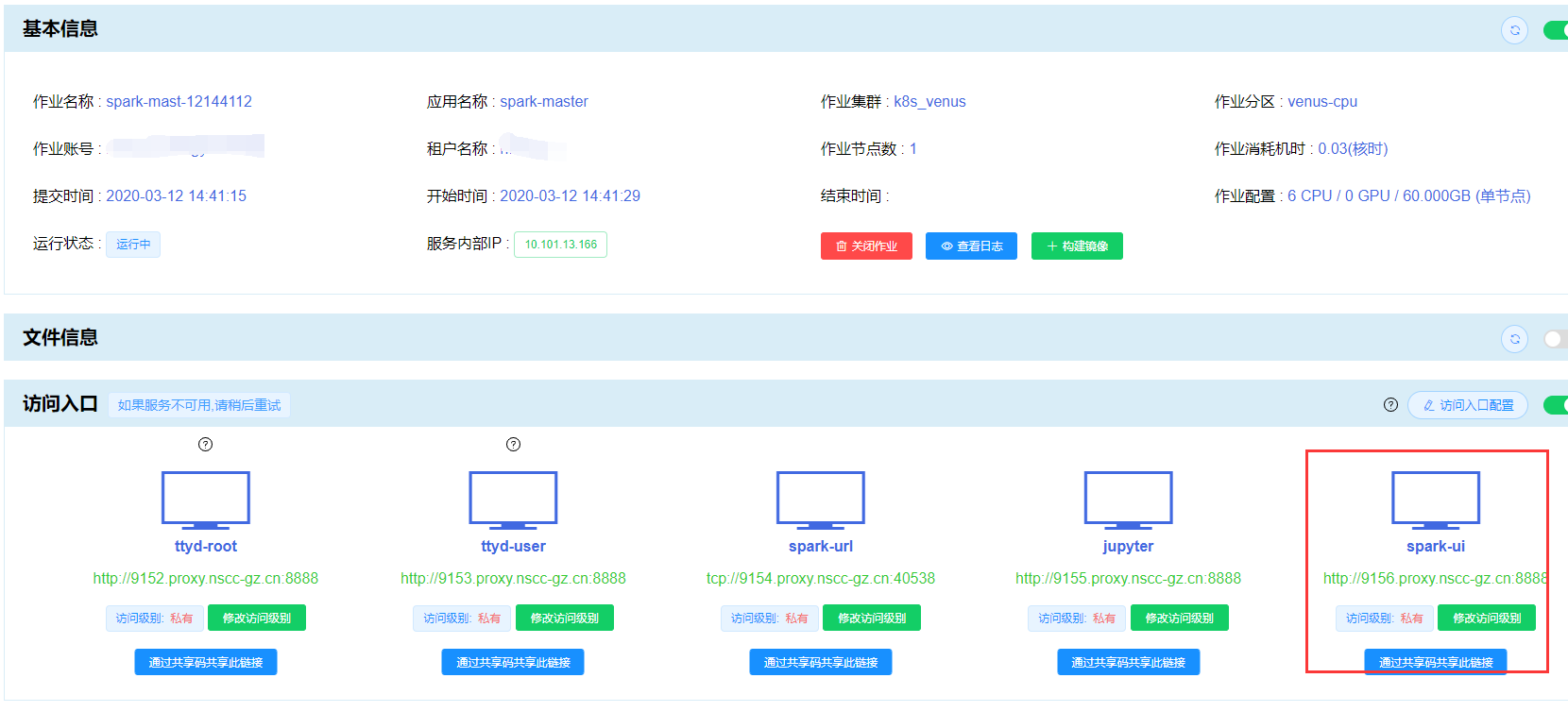

提交成功后自动进入作业详情界面:

通过访问入口访问 Spark-Master 应用,以 jupyter 和 sprak-ui 访问入口为例:

通过 Jupyter 访问 Spark-Master¶

点击 “jupyter” 访问入口:

使用 jupyter 登录需要 token 信息,token 信息需要到 “基本信息” 的 “查看日志” 中查看:

点击 “查看日志” 按钮,把日志拉到最后,可看见类似下面的 token 信息:

将 token 输入后点击 “登录” 按钮:

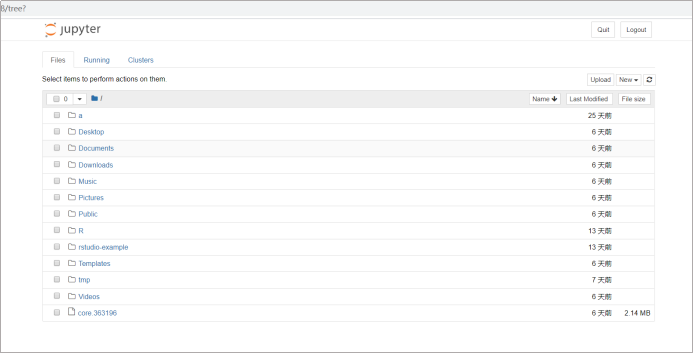

出现类似以下界面则表明登录成功:

通过 sprak-ui 访问 Spark-Master¶

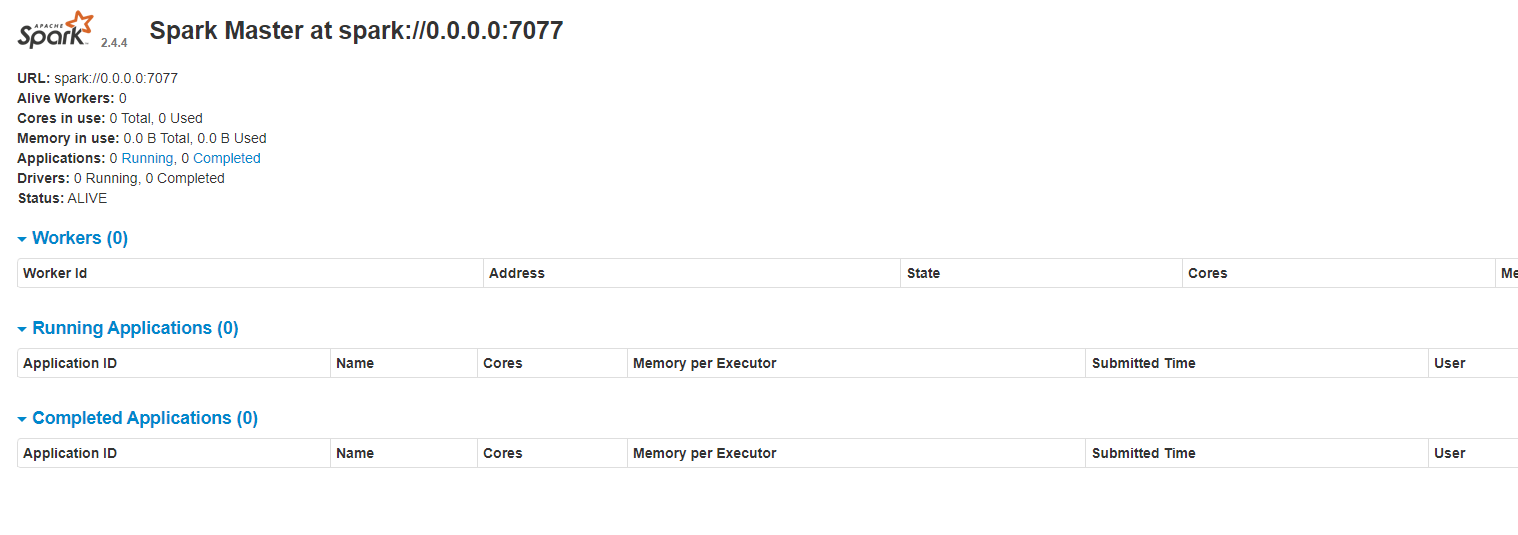

点击 “sprak-ui” 访问入口,使用 sprak-ui 访问入口访问应用:

注册 Spark-Worker¶

提交 Spark-Worker 应用作业

备注

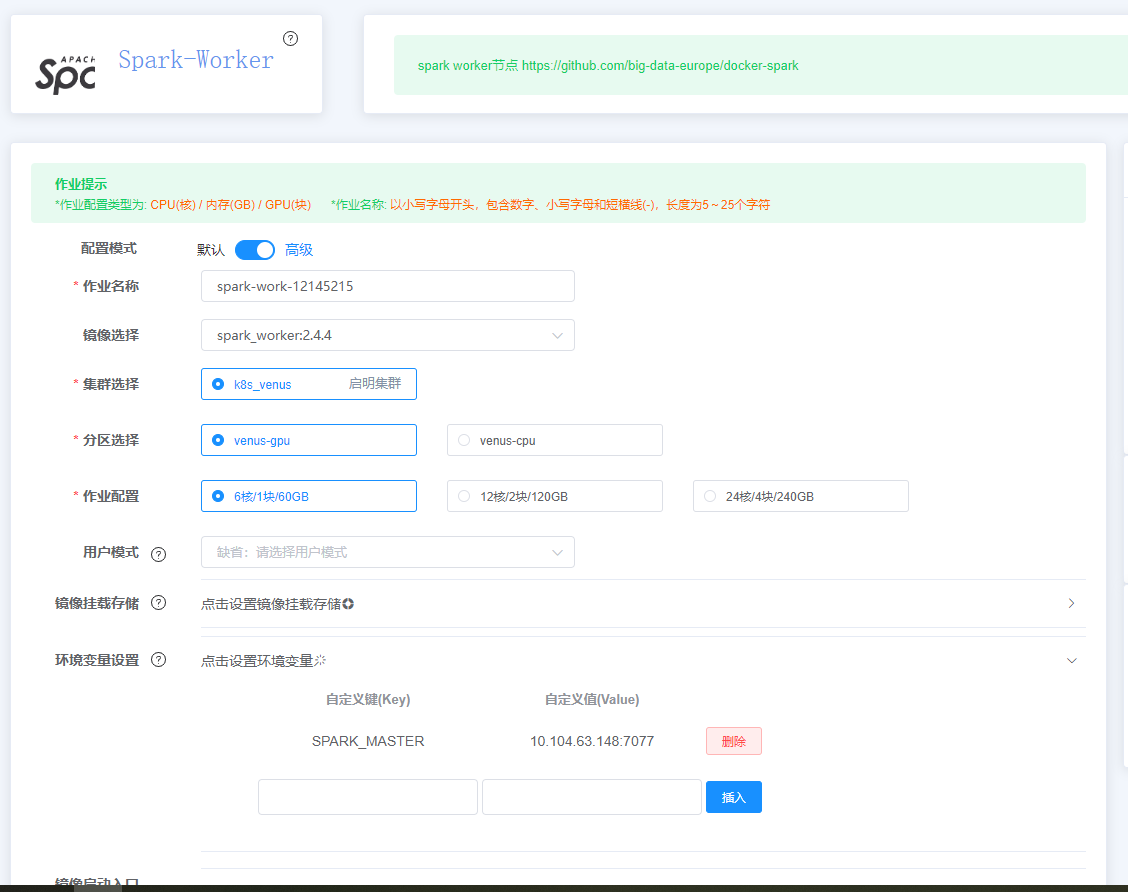

Spark-Worker 节点依赖于 Spark-Master 节点,创建 Spark-Worker 节点时需要使用高级配置模式配置环境变量 SPARK_MASTER,其值为 “Spark-Master的内部服务IP:端口号(一般为 7077)”。

Spark-Master 的内部服务 IP 可以在 Spark-Master 的作业详情界面查看:

如上图,将 SPARK_MASTER 值设为 10.104.63.148:7077 便可将 Spark-Worker 节点添加至对应集群。

Spark-Worker 的作业配置类似下图:

点击 “提交作业” 完成 Spark-Worker 的创建。

通过访问入口访问 Spark-Worker 应用,以 worker-ui 访问入口为例:

通过 worker-ui 访问 Spark-Worker¶

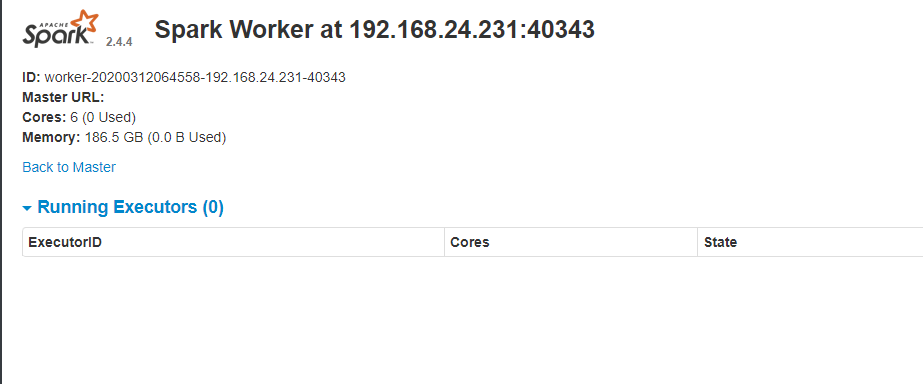

点击 “worker-ui” 访问入口:

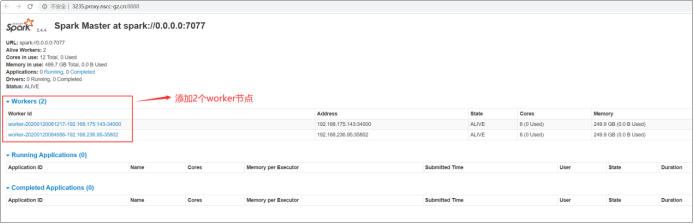

出现类似以下界面表示 Spark-Worker 创建成功:

查看集群信息¶

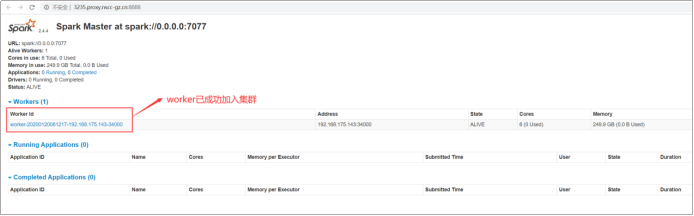

在 Spark-Master 节点查看集群信息:

出现类似以上界面,表明 worker 节点已成功加入集群,Spark 集群创建成功。

注意事项¶

用户在使用 Spark 应用时,有以下几点需要注意:

Spark 集群版应用创建后 spark 相关 URI-IP 为集群内部 IP ,不可外部访问(如 worker url 等链接不支持浏览器中直接打开)

底层文件系统不是 HDFS 文件系统,而是 Lustre 文件系统

Apache-Spark 应用默认安装路径为:

/spark,在 Spark-Worker 应用中没有将该路径加载到环境变量,若用户有需要,可使用命令自行加载:export PATH=/spark/bin:$PAT若用户想自定义配置 Apache-Spark ,可自行修改和配置 Spark-Master 应用中

/master.sh文件和 Spark-Worker 应用中/worker.sh文件(需要从 ttyd-root 登录,以 root 身份修改,且需要关闭现有的配置)Apache-Spark 的操作系统为 alpine-linux ,且已安装基本的程序开发、编译工具,如 gcc、python 等。在 alpine linux 中软件的安装、卸载操作使用的是 apk 命令,关于 alpinel linux 的更多信息可参考 https://alpinelinux.org/。